苹果人工智能研究揭示了一种模型,通过将任何给定的上下文转换为文本,可以更快、更高效地向 Siri 发出命令,而文本更容易被大型语言模型解析。

随着苹果公司即将在 6 月WWDC期间公开推出其人工智能计划,该公司的人工智能研究不断发表。迄今为止已经发表了多种研究成果,其中包括图像动画工具。

最新论文由VentureBeat率先分享。该论文详细介绍了 ReALM——参考解析作为语言建模。

让计算机程序基于模糊的语言输入执行任务,例如用户可能会说“这个”或“那个”,这称为参考解析。这是一个需要解决的复杂问题,因为计算机无法像人类那样解释图像,但苹果可能已经使用法学硕士找到了简化的解决方案。

当与Siri等智能助手交谈时,用户可能会引用任意数量的上下文信息进行交互,例如后台任务、显示数据和其他非会话实体。传统的解析方法依赖于令人难以置信的大型模型和图像等参考材料,但苹果通过将所有内容都转换为文本来简化了该方法。

Apple 发现其最小的 ReALM 模型的性能与 GPT-4 类似,但参数少得多,因此更适合在设备上使用。增加 ReALM 中使用的参数使其性能大大优于 GPT-4。

性能提升的原因之一是 GPT-4 依赖图像解析来理解屏幕上的信息。大部分图像训练数据都是建立在自然图像的基础上,而不是基于人工代码的充满文本的网页,因此直接 OCR 效率较低。

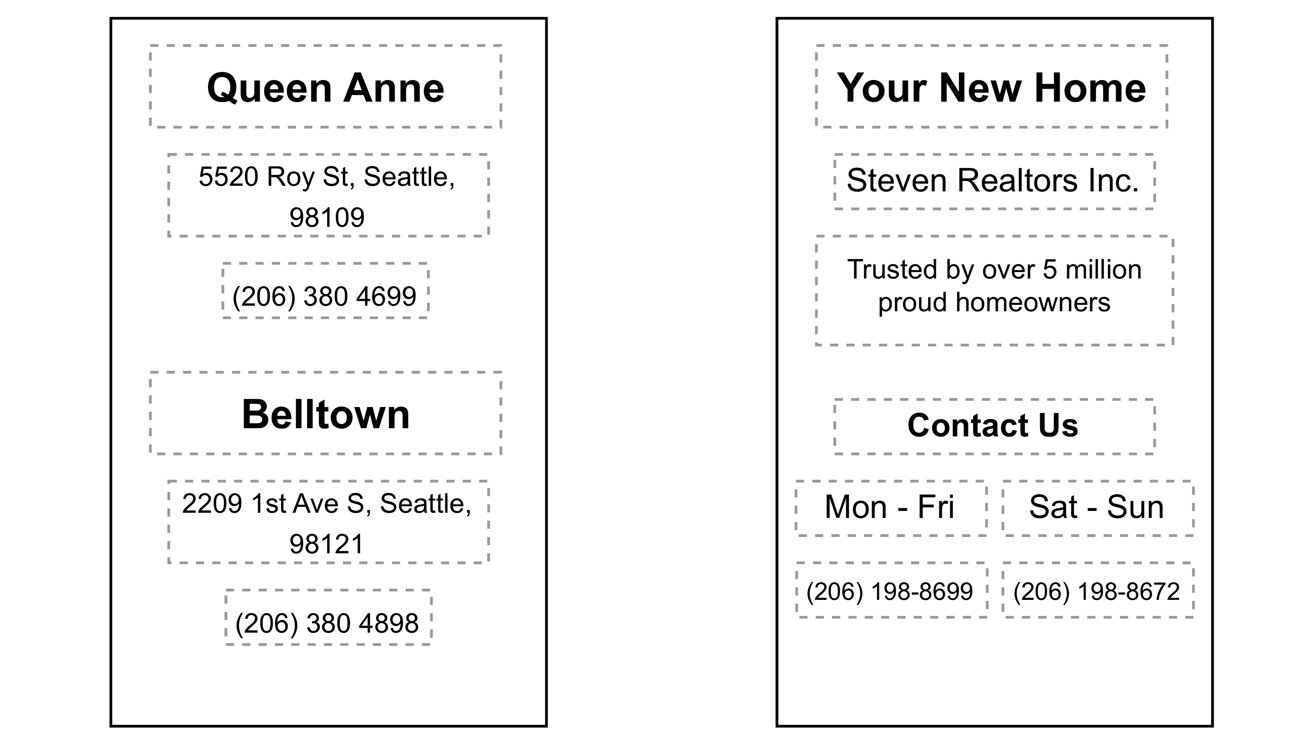

将屏幕捕获数据表示为文本。资料来源:苹果研究

将图像转换为文本使 ReALM 无需这些高级图像识别参数,从而使其更小、更高效。苹果还通过限制解码或使用简单后处理的能力来避免幻觉问题。

例如,如果您滚动浏览网站并决定致电该公司,只需说“致电该公司”,Siri 就会根据上下文解析您的意思。它将能够“看到”页面上有一个标记为企业号码的电话号码,并在没有进一步用户提示的情况下拨打它。

苹果正致力于在 WWDC 2024 期间发布全面的人工智能战略。一些传言称,该公司将依赖较小的设备内模型来保护隐私和安全,同时授权其他公司的法学硕士进行更具争议性的设备外处理,其中充满了道德难题。